【开源项目】GPT Academic 安装配置全教程

本文最后更新于 2024-05-06,文章内容可能已经过时。

项目介绍

为GPT/GLM等LLM大语言模型提供实用化交互接口,特别优化论文阅读/润色/写作体验,模块化设计,支持自定义快捷按钮&函数插件,支持Python和C++等项目剖析&自译解功能,PDF/LaTex论文翻译&总结功能,支持并行问询多种LLM模型,支持chatglm3等本地模型。接入通义千问, deepseekcoder, 讯飞星火, 文心一言, llama2, rwkv, claude2, moss等。

项目地址:【点击进入】

安装部署

安装方法I:直接运行 (Windows, Linux or MacOS)

-

下载项目

# 首先配置代理,便于下载项目 export http_proxy="127.0.0.1:7897" && \ export https_proxy="127.0.0.1:7897" git clone --depth=1 https://github.com/binary-husky/gpt_academic.git # 取消代理 unset http_proxy && unset https_proxy默认情况下,仓库会被下载到您在终端中运行该命令的当前工作目录中。

除了上述 git命令下载之外,也可以选择直接【点击】下载项目文件。

如何查看自己的代理地址:

方法一:直接到代理软件里查看,不同软件方式有所不同。

方法二:打开网页,然后按F12,点击网络,点击json,进行查看代理地址即可。

-

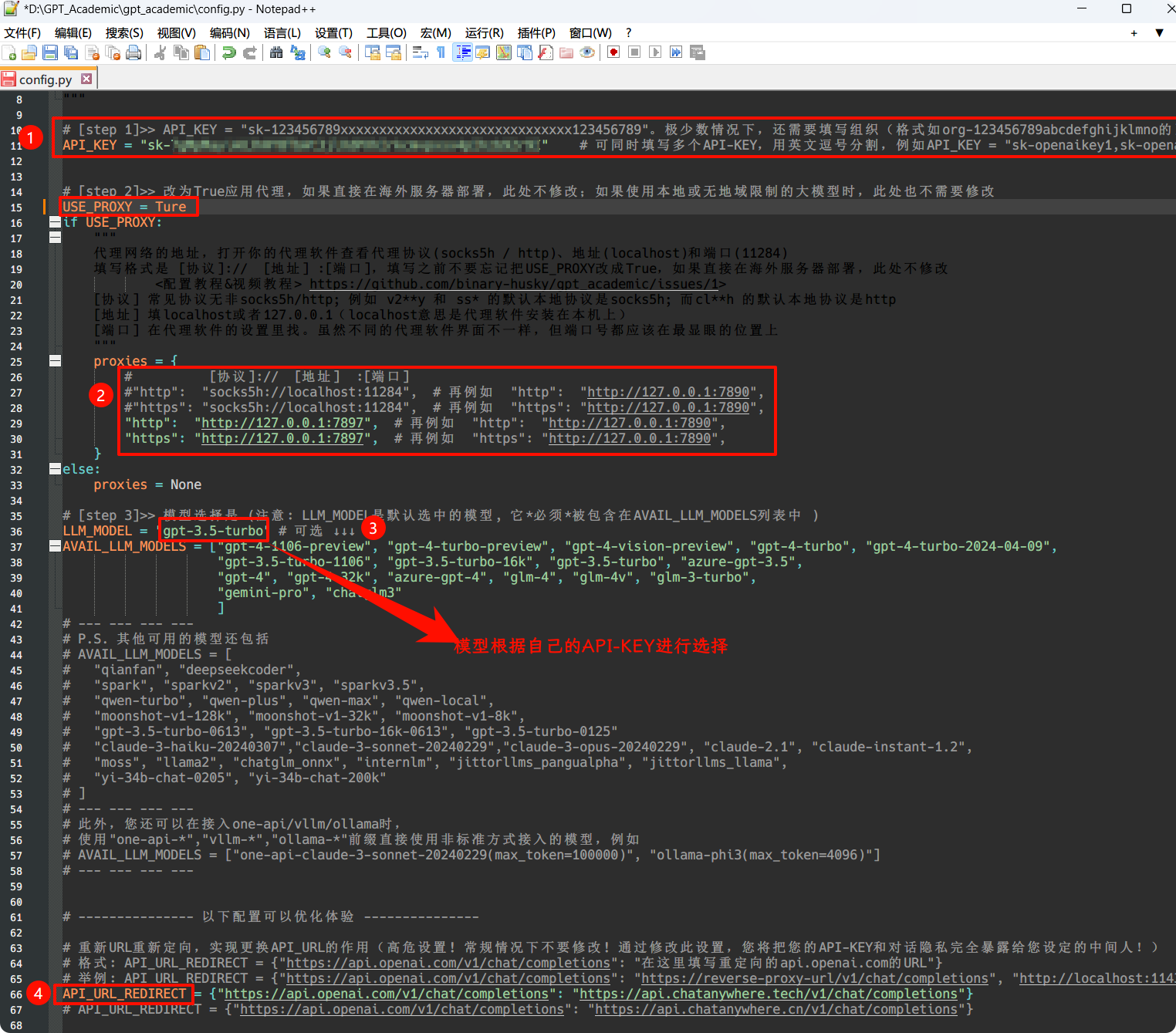

修改 config.py 配置文件

在

config.py中,配置API KEY等变量。特殊网络环境设置方法、Wiki-项目配置说明。

「 程序会优先检查是否存在名为

config_private.py的私密配置文件,并用其中的配置覆盖config.py的同名配置。如您能理解以上读取逻辑,我们强烈建议您在config.py同路径下创建一个名为config_private.py的新配置文件,并使用config_private.py配置项目,从而确保自动更新时不会丢失配置 」。「 支持通过

环境变量配置项目,环境变量的书写格式参考docker-compose.yml文件或者我们的Wiki页面。配置读取优先级:环境变量>config_private.py>config.py」。 -

安装依赖

选择I: 如熟悉python, python推荐版本 3.9 ~ 3.11

# 备注:使用官方pip源或者阿里pip源, 临时换源方法:python -m pip install -r requirements.txt -i https://mirrors.aliyun.com/pypi/simple/ cd gpt_academic # 进入项目目录 python -m pip install -r requirements.txt可以参考代码小白也能快速上手的chatgpt学术优化部署教程_bilibili,很简单。

选择II: 使用Anaconda,步骤也是类似的

在Anaconda Prompt执行以下命令:

conda create -n gptac_venv python=3.11 # 在(Anaconda Prompt)创建环境 conda activate gptac_venv # 激活anaconda环境/进入环境 # 在项目的根目录安装依赖 cd gpt_academic # 进入项目目录(每个人存放目录不同,要更改相应命令) python -m pip install -r requirements.txt

可以参考【chatGPT】从0开始教你搭建本地GPT-Academic,助力学术研究&&中科院ChatGPT学术优化

-

运行主函数

python main.py # 接着上一步可以在 Anaconda Prompt 直接运行 # Vscode 终端运行 C:\Users\Guoyi\anaconda3\Scripts\activate # 每个人不一样 conda activate gptac_venv python main.py

安装方法II:使用Docker

-

部署项目的全部能力(这个是包含cuda和latex的大型镜像。但如果您网速慢、硬盘小,则不推荐该方法部署完整项目

# 修改docker-compose.yml,保留方案0并删除其他方案。然后运行: docker-compose up -

仅ChatGPT + GLM4 + 文心一言+spark等在线模型(推荐大多数人选择https://github.com/binary-husky/gpt_academic/actions/workflows/build-with-audio-assistant.yml)

# 修改docker-compose.yml,保留方案1并删除其他方案。然后运行: docker-compose up

P.S. 如果需要依赖Latex的插件功能,请见Wiki。另外,您也可以直接使用方案4或者方案0获取Latex功能。

-

ChatGPT + GLM3 + MOSS + LLAMA2 + 通义千问(需要熟悉Nvidia Docker运行时)

# 修改docker-compose.yml,保留方案2并删除其他方案。然后运行: docker-compose up

安装方法III:其他部署方法

- Windows一键运行脚本。 完全不熟悉python环境的Windows用户可以下载Release中发布的一键运行脚本安装无本地模型的版本。脚本贡献来源:oobabooga。(最方便、最简单)😍

- 使用第三方API、Azure等、文心一言、星火等,见Wiki页面

- 云服务器远程部署避坑指南。 请访问云服务器远程部署wiki

- 在其他平台部署&二级网址部署

- 使用Sealos一键部署。

- 使用WSL2(Windows Subsystem for Linux 子系统)。请访问部署wiki-2

- 如何在二级网址(如

http://localhost/subpath)下运行。请访问FastAPI运行说明

总结

个人推荐直接Windows一键运行脚本 安装,方便省事,不想用了直接删除文件夹即可。

效果预览

- 感谢你赐予我前进的力量