轻松本地部署 Llama3 – 8B/70B 大型模型

前言

在当前的开源大型语言模型领域,Llama3模型以其卓越的性能脱颖而出。Meta公司不仅免费地公开了8B和70B两个功能强大的模型,而且即将推出400B模型,这将是一个能够与GPT-4相媲美的强大工具。

今天,我们将向您介绍四种简单易懂的本地部署方法,非常适合初学者学习和应用。

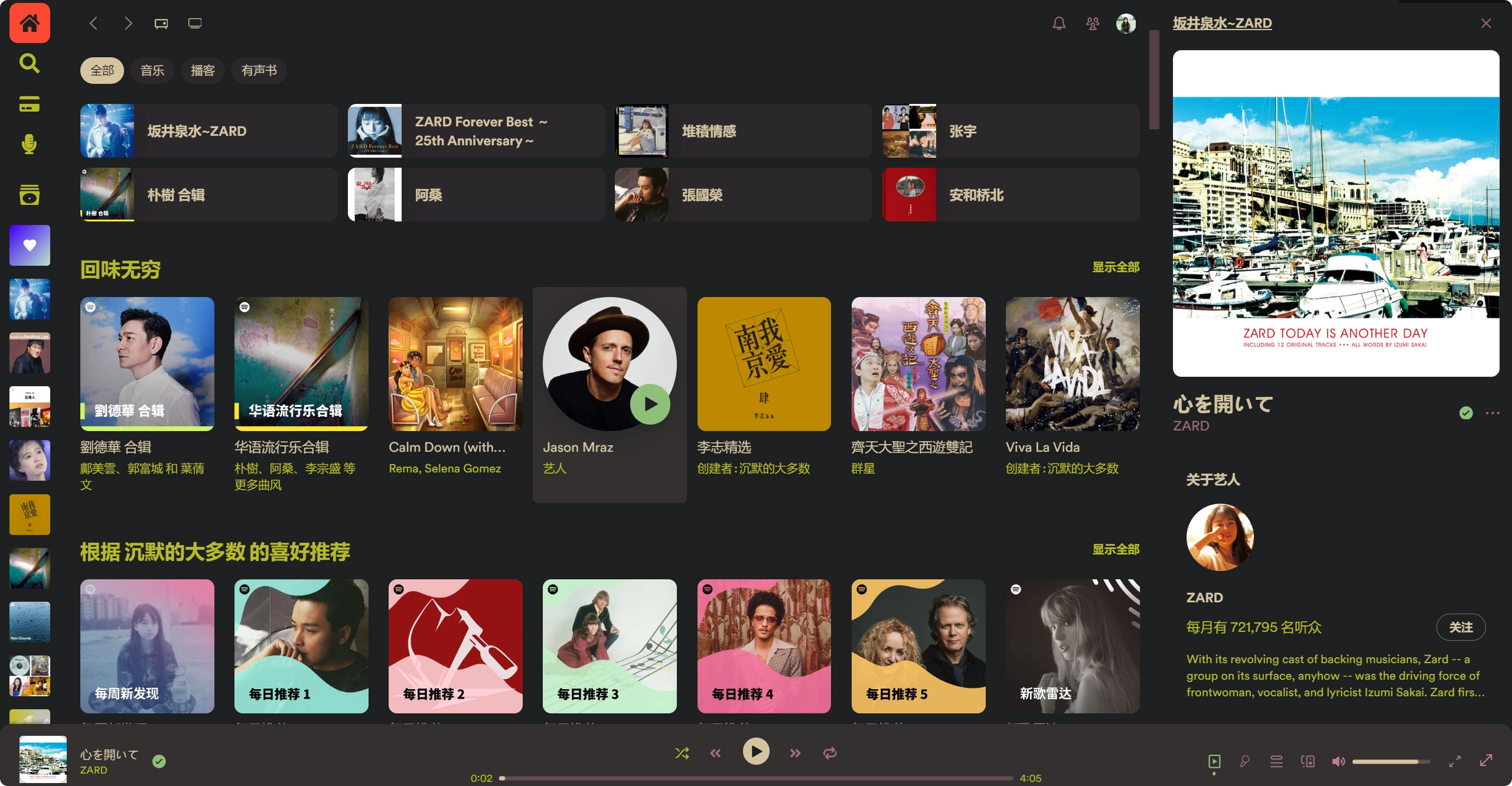

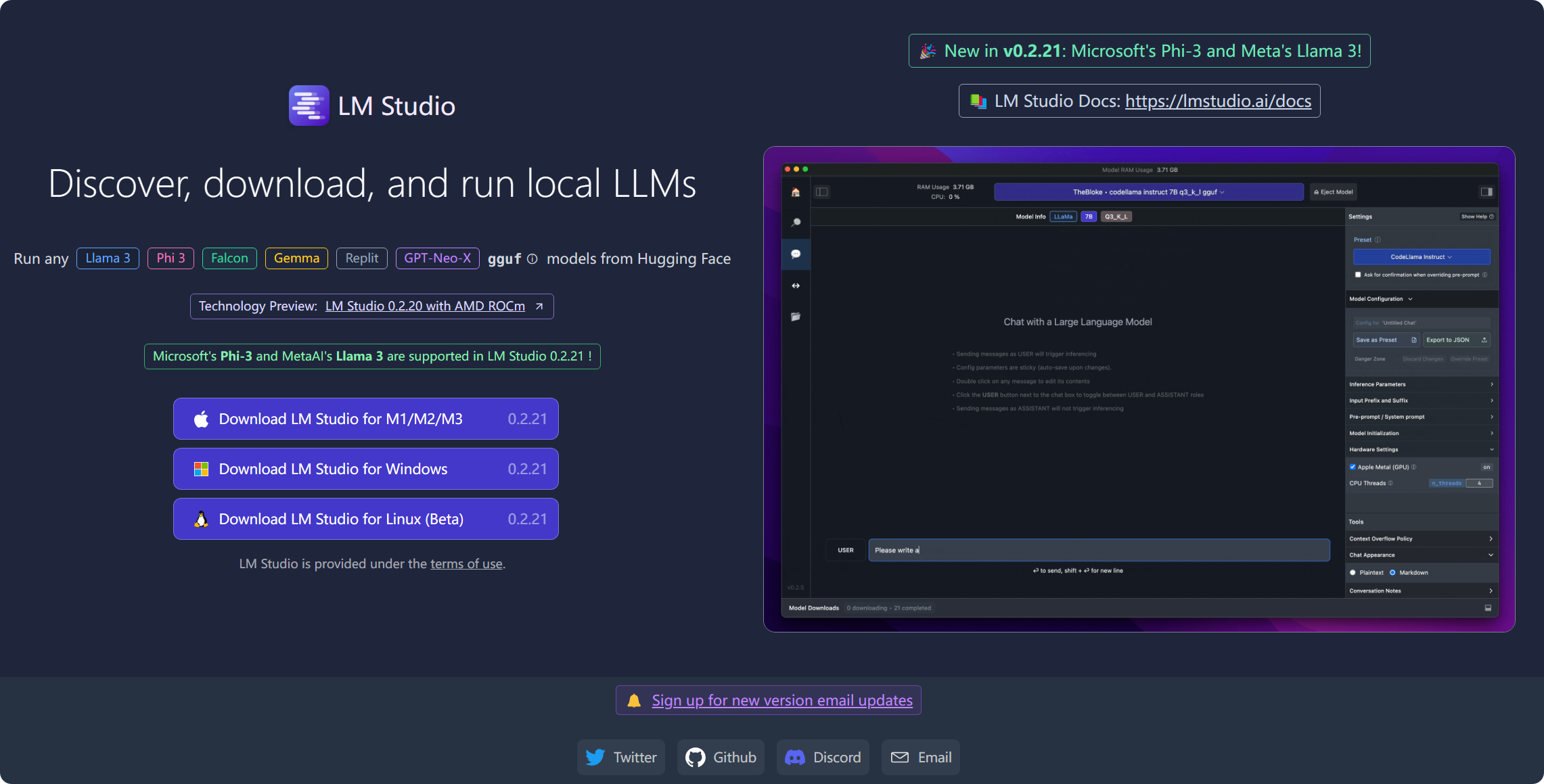

LMstudio

LMstudio 是一款发现、查找和运行本地 LLM 集成开发环境或平台。

它提供用户友好的界面、支持自定义模型训练、简化部署流程、具备协作工具、集成多种开发工具、拥有活跃的开源社区,以及提供全面的文档和技术支持,旨在帮助用户高效地开发和优化大型语言模型。

👉官网【点击进入】

📚 LM Studio 文档:https://lmstudio.ai/docs

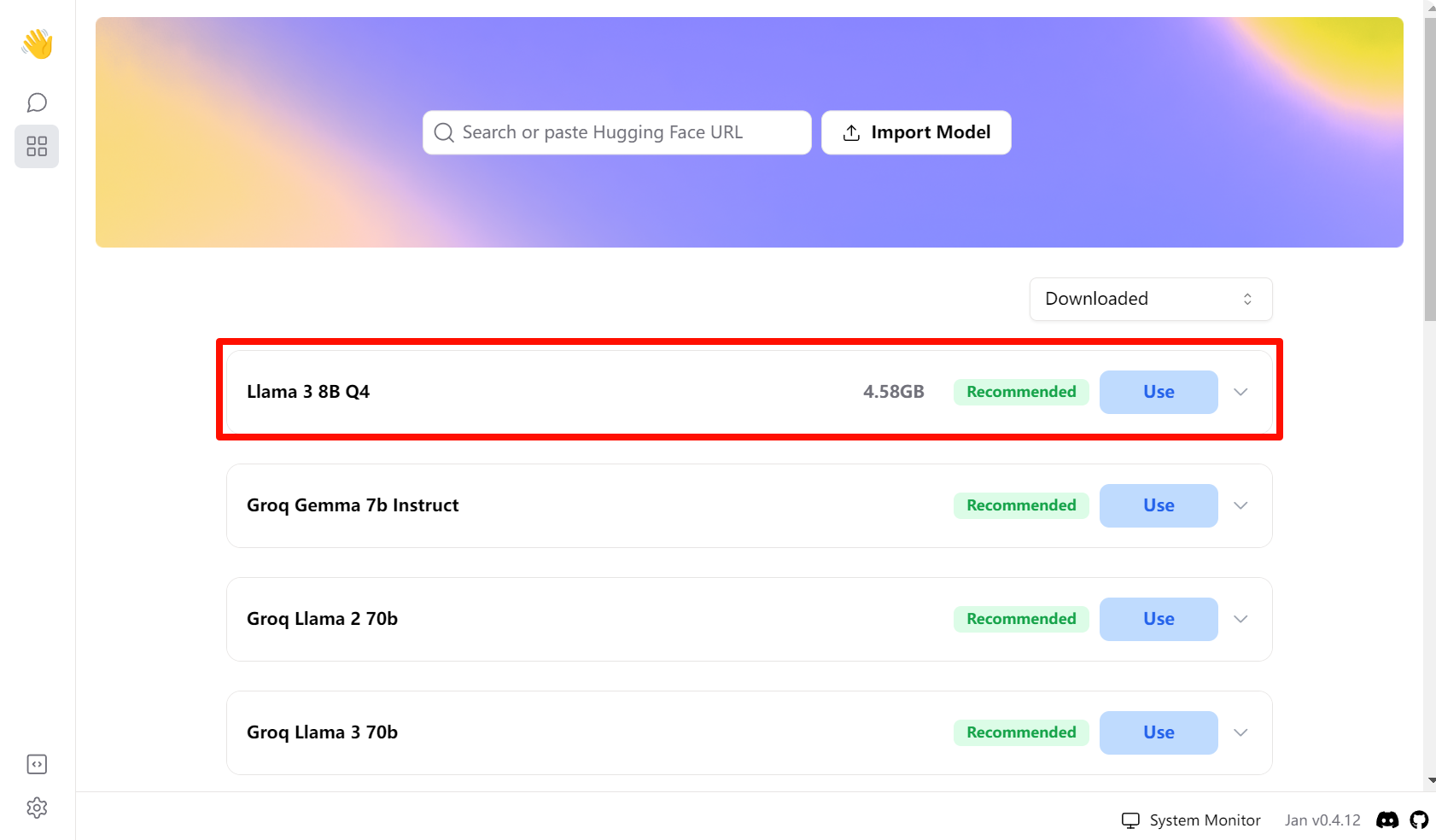

jan

Jan 作为一款开源的的本地 AI 部署软件,具体下载部署请参考我的另一篇帖子。

👉官网【点击进入】

下载设置好 Jan 后,在后台需要挂上代理,然后搜索 Llama3 模型下载即可。

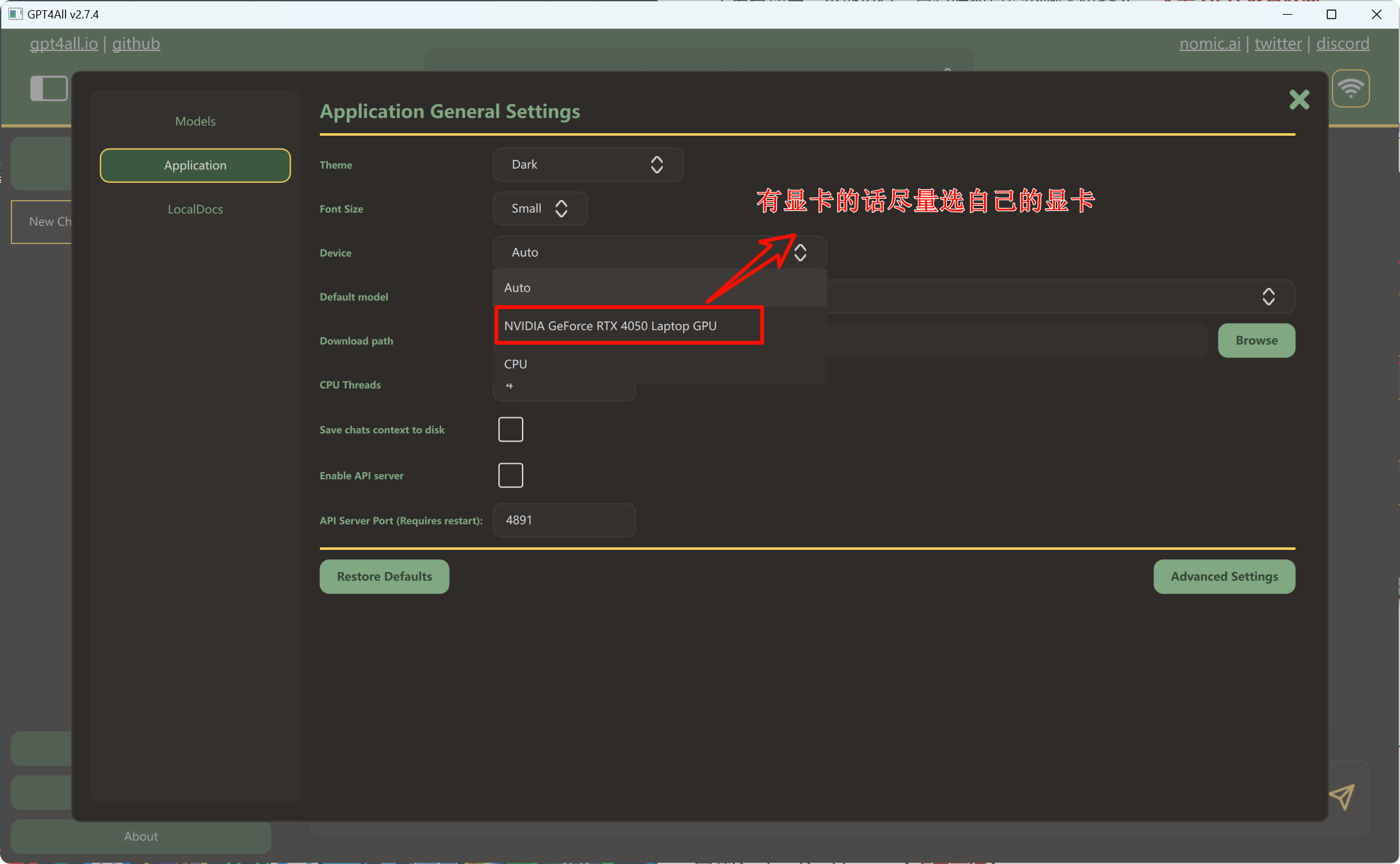

GPT4All

一个免费使用、本地运行、具有隐私意识的聊天机器人。 无需 GPU 或互联网。

GPT4All : 适合低配置用户,可以在CPU/GPU上运行。

👉官网【点击进入】

安装好软件后,开始下载大模型。

下载好 Llama3 大模型后,只需要在 Application 里设置以 CPU/GPU 运行,之后返回首页即可正常问答。

Tip:下载安装包后,记得右键以管理员身份运行安装包,可以更改安装路径。

Ollama

一款开源跨平台的可以启动并运行大语言模型软件!

👉Ollama 官网【点击进入】

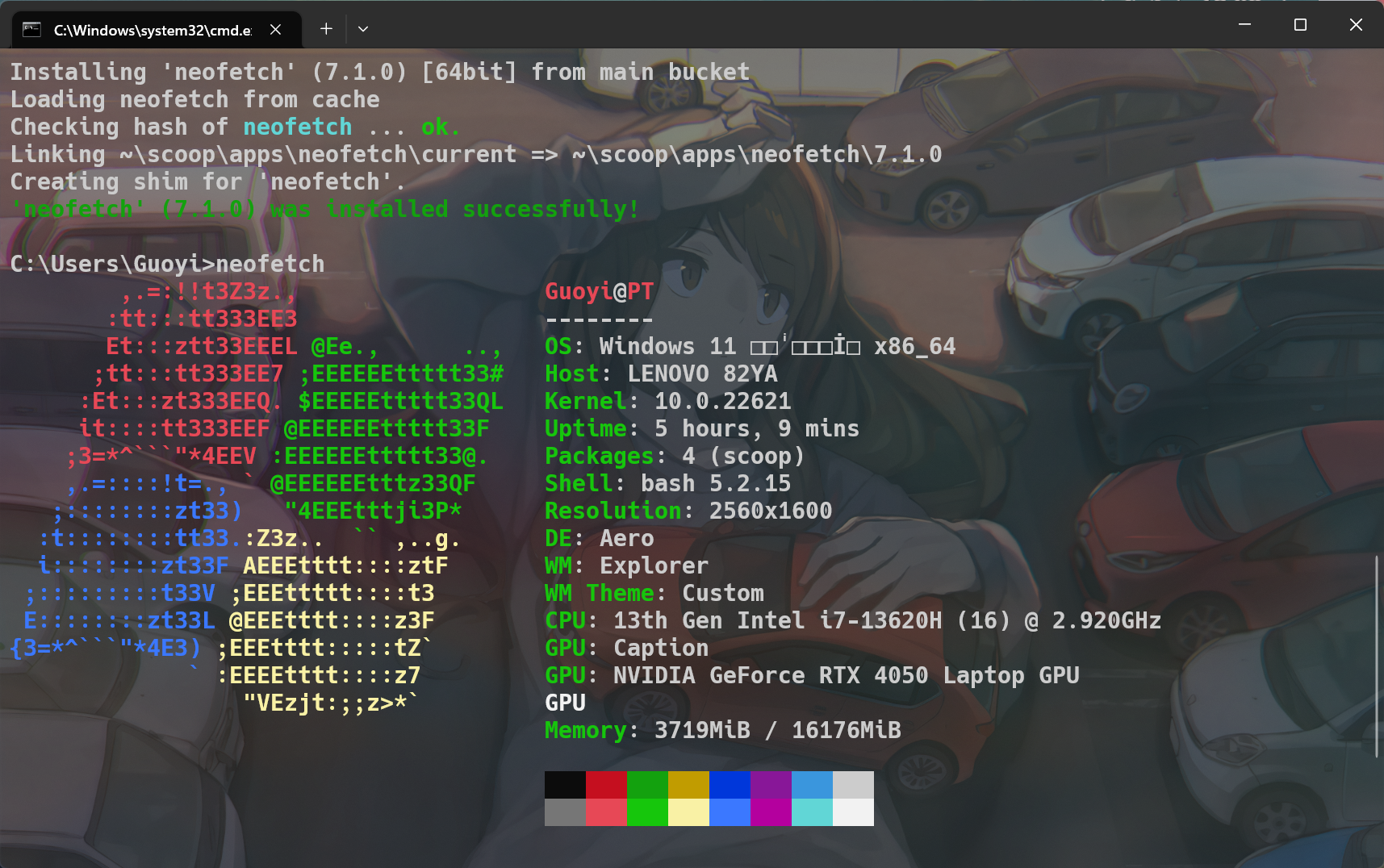

安装环境

在 Windows 上打开 WSL 功能:搜索「启用或关闭Windows功能」,然后勾选「适用于Linux的Windows子系统」即可。

接着安装Docker Desktop :【点击前往】官网下载安装包。

本地安装webUI

在CPU下运行:

docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main支持GPU运行:

docker run -d -p 3000:8080 --gpus=all -v ollama:/root/.ollama -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:ollama安装完成通过本地地址:http://127.0.0.1:3000 在浏览器进行访问。

##

- 感谢你赐予我前进的力量